Hallo,

für private Zwecke der Hausautomatisierung nutze ich seit Kurzem eine InfluxdB für die Speicherung von Sensorwerten. Die Performance durch die Speicherung in zeitlicher Abfolge habe ich bereits positiv bemerkt. Jedoch ist es nicht wirklich sinnvoll zB Sensordaten die alle paar Sekunden (zB Stromverbrauchsleistung) geliefert werden über einen ganzen Monat oder sogar später Jahr abzufragen und damit Berechnungen durchzuführen.

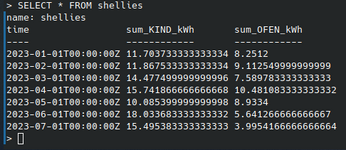

Nun würde es mir reichen, wenn die Daten auf zB 1h komprimiert werden. Hierzu müßte ich über 1h Das Integral bilden, ok. Aber das Ergebnis wiederum in die Datenbank zurück schreiben und ggf. alle Sekundenwerte löschen. Bzgl. des Konzeptes ist der Zeitstempel für mich ein Problem. InfluxDB speichert, soweit ich es weiß, automatisch den Zeitstempel und dieser ist auch nicht "manipulierbar". Wenn ich mir also später zB auch mal ein Diagramm ansehe ist es wichtig, dass der Zeitstempel des Integrals für 1h auch den Zeitstempel besitzt dieser Stunde. Selbes Problem bzgl. Woche und Monat. Tage kann ich noch direkt in der Abfrage bewältigen auch wenn es auf die Performance geht.

Lasse ich eine Berechnung zyklisch jede Stunde ausführen zum Komprimieren bin ich mit dem Zeitstempel der Speicherung auf jeden Fall in der nächsten angebrochenen Stunde.

Lässt sich sowas als mit einer solchen Datenbank gar nicht realisieren?

Thx!

für private Zwecke der Hausautomatisierung nutze ich seit Kurzem eine InfluxdB für die Speicherung von Sensorwerten. Die Performance durch die Speicherung in zeitlicher Abfolge habe ich bereits positiv bemerkt. Jedoch ist es nicht wirklich sinnvoll zB Sensordaten die alle paar Sekunden (zB Stromverbrauchsleistung) geliefert werden über einen ganzen Monat oder sogar später Jahr abzufragen und damit Berechnungen durchzuführen.

Nun würde es mir reichen, wenn die Daten auf zB 1h komprimiert werden. Hierzu müßte ich über 1h Das Integral bilden, ok. Aber das Ergebnis wiederum in die Datenbank zurück schreiben und ggf. alle Sekundenwerte löschen. Bzgl. des Konzeptes ist der Zeitstempel für mich ein Problem. InfluxDB speichert, soweit ich es weiß, automatisch den Zeitstempel und dieser ist auch nicht "manipulierbar". Wenn ich mir also später zB auch mal ein Diagramm ansehe ist es wichtig, dass der Zeitstempel des Integrals für 1h auch den Zeitstempel besitzt dieser Stunde. Selbes Problem bzgl. Woche und Monat. Tage kann ich noch direkt in der Abfrage bewältigen auch wenn es auf die Performance geht.

Lasse ich eine Berechnung zyklisch jede Stunde ausführen zum Komprimieren bin ich mit dem Zeitstempel der Speicherung auf jeden Fall in der nächsten angebrochenen Stunde.

Lässt sich sowas als mit einer solchen Datenbank gar nicht realisieren?

Thx!